[strumenti]

anno 16 numero 31 / 12.21

Biografia

Raffaele Tripiccione, dopo aver studiato all’Università di Pisa e alla Scuola Normale Superiore, è stato ricercatore Infn fino al 2000 e poi professore all’Università di Ferrara, fino alla sua improvvisa scomparsa, nel novembre 2021. La sua attività di ricerca, inizialmente nell’area della fenomenologia delle particelle elementari e della teoria di campo, ha riguardato la fisica teorica computazionale, in particolar modo lo studio delle proprietà statistiche dei sistemi complessi. Tripiccione ha avuto un ruolo importante nelle iniziative Infn relative allo sviluppo di sistemi di calcolo dedicati per la fisica teorica.

Strumenti informatici

Computer e reti in fisica

di Raffaele Tripiccione

a.

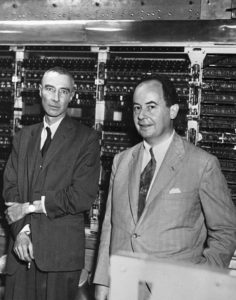

Robert Oppenheimer (a sinistra) e John Von Neumann di fronte alla macchina di calcolo più veloce dell’epoca (1952). Il computer era in grado di fare 2000 moltiplicazioni in un secondo e memorizzare 1024 numeri di 12 cifre decimali ciascuno.

Un’immagine un po’ romantica e certamente oggi non corrispondente alla realtà vede il fisico impegnato a copiare su un taccuino una manciata di numeri che legge sui quadranti di qualche strumento connesso al suo apparato sperimentale, eseguire su tali numeri qualche semplice analisi di tipo statistico e confrontare i risultati con le previsioni (anch’esse derivate con limitate operazioni matematiche) del modello teorico che vuole verificare. Quello che non corrisponde alla realtà in questa immagine è l’assenza di uno “strumento” di lavoro, diventato negli anni fondamentale e costituito dal supporto che i calcolatori e il relativo software danno a tutte le fasi di una ricerca in fisica, sia essa teorica o sperimentale.

Quello che cercheremo di passare in rassegna qui è il ruolo che gli strumenti di calcolo e informatici svolgono, in maniera sempre più coinvolgente, nel lavoro quotidiano della ricerca in fisica. Metteremo in evidenza anche un aspetto forse poco noto, ma importante nel rapporto tra fisica e computing, legato al fatto che, se da un lato oggi il lavoro del fisico dipende imprescindibilmente dagli strumenti di calcolo, è anche vero che la fisica, nel corso degli ultimi sessant’anni, ha dato un contributo significativo di idee originali e di innovazione allo sviluppo dei sistemi di calcolo come li intendiamo attualmente. Infine, una questione di linguaggio: il significato del termine “supercomputing” ha subito una forte evoluzione negli anni. Qui lo intenderemo semplicemente come l’insieme dei più potenti strumenti di calcolo che, ad ogni istante, sono disponibili per la ricerca di base, date le risorse economiche ragionevolmente disponibili allo scopo.

Iniziamo con una veloce carrellata di alcune cruciali innovazioni che rappresentano il contributo dei fisici al computing a livello globale. Un fondamentale contributo è quello di John Von Neumann, uno dei padri della meccanica quantistica, che nel 1945 propose un modello concettuale dell’architettura dei calcolatori che è tuttora un importante strumento di inquadramento concettuale. Un modello che è sopravvissuto alla rivoluzionaria evoluzione tecnologica del transistor (inventato da tre fisici, John Bardeen, Walter Brattain e William Shockley) e poi del circuito integrato (portato a maturazione dal lavoro di un altro fisico, Jack Kilby). Un ulteriore contributo importante della comunità dei fisici allo sviluppo del principio dei calcolatori è la dimostrazione che il calcolo computazionale parallelo (parallel computing) – l’idea che per migliorare le prestazioni di un sistema di calcolo è più conveniente eseguire tante operazioni in parallelo, magari più lentamente, piuttosto che una di seguito all’altra ma molto velocemente – era una strada perseguibile in pratica. Questa dimostrazione di fattibilità, cui l’Infn ha dato un significativo contributo negli anni ’80 e ’90 dello scorso secolo con lo sviluppo dei calcolatori Ape (vd. approfondimento), dedicati allo studio teorico dell’interazione forte, ha prodotto un cambiamento drastico nelle architetture di calcolo, che oggi sono tutte fortemente parallelizzate.

L’esperienza di Ape ci ricorda che l’utilizzo dei calcolatori per la ricerca in fisica è iniziato in ambito teorico. La prima significativa evidenza che il computing fosse uno strumento importante per la fisica è dei primi anni ’50, quando Enrico Fermi e collaboratori (John Pasta, Stanislaw Ulam, Mary Tsingou) mostrarono non solo che i calcolatori, anche quelli primitivi degli anni ’50, potevano essere utilizzati per simulare la dinamica dei sistemi fisici, ma anche – fatto ancora più importante e sorprendente – che da queste simulazioni si ottenevano risultati nuovi e del tutto inattesi. Enrico Fermi si chiese cosa succede se si introducono accoppiamenti non lineari tra i nodi di una catena di oscillatori armonici accoppiati. L’inaspettata risposta ottenuta dalla simulazione numerica è che l’approccio all’equilibrio del sistema, previsto dall’ipotesi ergodica, è molto più lento del previsto, un problema ancora oggi parzialmente aperto e che ha dato il via allo studio della fisica dei sistemi non lineari.

b.

Una delle sale macchine del Cnaf, il centro nazionale dell’Infn per la ricerca e lo sviluppo nelle tecnologie informatiche e telematiche, che ospita alcuni dei più potenti supercomputer italiani.

Questa linea di evoluzione si è ampliata senza sosta e oggi, grazie a risorse di calcolo ingenti, sappiamo simulare l’evoluzione di sistemi fisici di grande complessità: abbiamo imparato a calcolare come si muovono tutti i corpi del sistema solare (inclusi i satelliti artificiali, che sappiamo guidare con precisione sui loro obiettivi) ma sappiamo anche predire cosa succede nella coalescenza di due buchi neri che producono le onde gravitazionali rilevate dagli esperimenti Virgo-Ligo. Il livello di accuratezza raggiunto da questo tipo di analisi, a fronte peraltro di un impegno di calcolo imponente (alcune simulazioni numeriche possono richiedere mesi di calcoli in supercomputer con decine di migliaia di processori), è impressionante. Per rimanere in un’area di interesse per l’Infn, le simulazioni reticolari permettono oggi di valutare gli elementi di matrice della corrente debole sugli stati adronici con un’accuratezza dell’ordine del percento. E questi numeri sono fondamentali per verificare a partire dai dati sperimentali la correttezza del modello standard e per porre limiti stringenti su possibili modelli di nuova fisica.

Un impatto altrettanto forte viene dai calcolatori a supporto dell’attività sperimentale, soprattutto nell’ambito della fisica delle interazioni fondamentali. In questo contesto, il ruolo chiave svolto dai calcolatori è quello di gestire e analizzare l’enorme quantità di dati proveniente dagli apparati sperimentali: gli esperimenti di Lhc producono qualche decina di petabyte (1016 byte) di dati per anno, in modo da isolare gli eventi fisicamente interessanti e derivare da essi le quantità da confrontare con le predizioni teoriche. Una sfida che ha portato allo sviluppo della Computing Grid, oggi evoluta nel concetto di Computing Cloud, ormai adottato in modo universale (vd. Asimmetrie n. 13, ndr).

Da questo tipo di analisi emerge chiaramente una nuova direzione di sviluppo, caratterizzata dall’utilizzo sempre più significativo di tecniche di intelligenza artificiale. In particolare, il machine learning sta affiancando (e probabilmente soppiantando) tecniche di analisi tradizionali in aree come la classificazione degli eventi e l’identificazione di particelle (vd. Caduti nella rete (neurale), ndr). Vanno ancora chiariti alcuni aspetti legati alla stima degli errori, di fondamentale importanza in fisica, ma la strada è ormai chiaramente aperta.

Nel futuro più lontano, in fisica ma anche in altri campi della scienza e dell’ingegneria, si delinea lo sviluppo dei computer quantistici, calcolatori che seguono le leggi della meccanica quantistica. La sostituzione del bit (in grado di immagazzinare uno 0 oppure un 1) con il “q-bit” (che può essere contemporaneamente in una arbitraria sovrapposizione dello stato |0> e dello stato |1>) permette a un sistema di N q-bit di eseguire un’operazione contemporaneamente su 2N diversi valori numerici, incrementando esponenzialmente le prestazioni di calcolo. I problemi (sia concettuali che tecnologici) da risolvere sono ancora molti e richiederanno anni di lavoro e ingenti investimenti, ma l’aspettativa è di poter simulare realisticamente sistemi fisici in tutti i loro dettagli quantistici, come pure di risolvere problemi di ottimizzazione e di classificazione con una risoluzione estremamente più elevata di quella attuale.

[as] approfondimento

L’Ape digitale

1.

1986, il primo Ape (denominato simpaticamente “Apetto”), con (da sinistra) Enzo Marinari, Pier Stanislao Paolucci, Nicola Cabibbo, (della sezione Infn di Roma Sapienza), in piedi, e Gaetano Salina (della sezione Infn di Tor Vergata), seduto.

L’Infn ha avuto un ruolo importante nel campo del calcolo parallelo tra la metà degli anni ’80 e il 2000, con lo sviluppo dei calcolatori paralleli Ape, ottimizzati per lo studio della cromodinamica quantistica – la teoria delle interazioni forti – con tecniche Monte Carlo su reticolo (vd. Calcolando per punti, ndr). Il problema fisico era quello di ricavare predizioni quantitative per una teoria che non poteva essere trattata con un approccio perturbativo. Kenneth Wilson, già dieci anni prima, aveva riformulato la teoria in modo da poterla studiare con tecniche numeriche, ma l’enorme mole di calcolo richiesta era un ostacolo insormontabile. C’era però una nuova via da esplorare, offerta dal forte parallelismo dell’algoritmo: si dovevano eseguire esattamente le stesse operazioni matematiche sui dati associati a tutti i punti del reticolo e queste operazioni potevano essere eseguite contemporaneamente. Era una situazione forse troppo banale per destare l’interesse della ricerca informatica, ma troppo appetitosa per dei fisici che volevano calcolare le masse degli adroni. Da qui l’intuizione, in gran parte di Nicola Cabibbo e Giorgio Parisi (insignito lo scorso ottobre del premio Nobel per la fisica), di realizzare un sistema di calcolo molto semplice, ma fortemente parallelo. Nella prima versione della macchina c’erano ben 16 nodi di calcolo e ognuno di essi eseguiva contemporaneamente 8 operazioni matematiche su numeri reali. Il prototipo di Ape non era certo un esempio di industrial design, ma aveva una potenza di calcolo equivalente a un intero supercalcolatore Cray, il meglio del meglio all’epoca, ed era disponibile al 100% per la fisica. Generazioni successive della macchina hanno esteso il parallelismo a migliaia di processori. Lo scetticismo iniziale era palpabile, ma gli straordinari risultati scientifici ottenuti da Ape hanno avuto un ruolo non trascurabile nel convincere la comunità della ricerca e l’industria dei calcolatori che si potevano utilmente eseguire tante operazioni su un singolo processore e anche far lavorare insieme in modo efficiente tanti diversi processori. Il “modello standard” di supercomputer di oggi, con decine di migliaia di nodi, ognuno dei quali esegue contemporaneamente migliaia di operazioni matematiche, è l’evoluzione di Ape resa possibile da venti anni di ingenti investimenti industriali.

Biografia

Raffaele Tripiccione, dopo aver studiato all’Università di Pisa e alla Scuola Normale Superiore, è stato ricercatore Infn fino al 2000 e poi professore all’Università di Ferrara, fino alla sua improvvisa scomparsa, nel novembre 2021. La sua attività di ricerca, inizialmente nell’area della fenomenologia delle particelle elementari e della teoria di campo, ha riguardato la fisica teorica computazionale, in particolar modo lo studio delle proprietà statistiche dei sistemi complessi. Tripiccione ha avuto un ruolo importante nelle iniziative Infn relative allo sviluppo di sistemi di calcolo dedicati per la fisica teorica.