[IA]

anno 20 numero 39 / 10.25

Biografia

Daniele Bonacorsi è professore di fisica sperimentale all’Università di Bologna. Lavora da tempo in esperimenti al CERN con acceleratori di particelle. Ha lavorato alla progettazione, sviluppo e messa in opera della Grid per gli esperimenti di LHC ed è stato coordinatore internazionale del calcolo scientifico dell’esperimento CMS a LHC, dove ha promosso l’adozione di tecniche di machine learning e deep learning. Tiene corsi di deep learning e quantum machine learning e coordina il dottorato in data science and computation all’Università di Bologna.

Ex machina

L’evoluzione dell’intelligenza artificiale

di Daniele Bonacorsi

Negli ultimi anni, il termine “intelligenza artificiale” (IA) ha subìto una rapida transizione da concetto puramente specialistico a espressione d’ampio uso quotidiano. Forte dei suoi successi e di una evidente ubiquità nella discussione pubblica, nonché di una pervasività senza precedenti nel mondo delle applicazioni software, dietro l’IA si nasconde tuttavia una lunga storia che alterna intuizioni geniali a progressi discontinui. Tale disciplina, dalle origini a oggi, ha seguito infatti un percorso complesso, che da alcuni anni sembra vivere un’esplosione senza fine, con evidenti impatti nella ricerca scientifica e nelle applicazioni tecnologiche e industriali. Oggi l’IA non è soltanto una delle sfide scientifiche e tecnologiche più ambiziose del nostro tempo, ma anche, e sempre più, un elemento profondamente trasformativo del tessuto della nostra società, che permea ambiti cruciali come il mondo del lavoro, le relazioni sociali, i sistemi di comunicazione, le modalità di accesso all’informazione, l’educazione, l’economia e molti processi decisionali, tanto individuali quanto collettivi.

Analizzandola fin dalle sue origini, quella dell’IA è una storia fatta di alti e bassi. Le sue radici affondano in un primo modello matematico semplificato del neurone, proposto nel 1943 da Warren McCulloch e Walter Pitts, che dimostrarono come “reti” di unità binarie potessero, in linea di principio, realizzare qualsiasi computazione logica. Nel 1958, Frank Rosenblatt introdusse il “percettrone”, un primo modello di strato di neuroni artificiali in grado di imparare da esempi mediante calcoli su cifre non più solo binarie, e passò poi anche alla disposizione su più strati (“layers”). Stavano nascendo le “reti neurali artificiali”, ovvero modelli computazionali ispirati alla struttura del cervello umano, composte da unità elementari (“neuroni” artificiali) interconnesse e organizzate in strati, in grado di elaborare informazioni complesse attraverso la propagazione e trasformazione di segnali numerici. Fu l’inizio della realizzazione di un sogno: quello di replicare, con metodi computazionali, alcune capacità cognitive tipiche degli esseri umani.

Tuttavia, il progresso fu irto di rallentamenti e ostacoli tecnici. Già negli anni ’70 si verificarono i primi “inverni dell’IA”, lunghi periodi di stasi e disillusione, causati dai limiti teorici e computazionali dell’epoca: i modelli erano infatti troppo semplici per affrontare compiti complessi. Un punto di svolta cruciale nella storia dell’IA avvenne negli anni ’80, con lo sviluppo di metodi efficaci per addestrare reti neurali su dati reali.

Prima di approfondire tali metodi, occorre ricordare che in quegli anni tutti questi algoritmi erano descritti nel cosiddetto “machine learning” (apprendimento automatico). Si tratta di una classe di algoritmi che consente ai computer di apprendere schemi e regole decisionali a partire dai dati, senza la necessità di una programmazione esplicita basata su regole. Questi sistemi sono in grado di generalizzare dagli esempi osservati per effettuare previsioni o prendere decisioni su input mai visti prima, e sono oggi alla base di moltissime applicazioni (vd. anche Nello zoo galattico, ndr). Solo nel secondo decennio del secolo corrente, invece, si è affermata una sotto-classe dell’apprendimento automatico, il cosiddetto “deep learning” (apprendimento profondo). Basate su reti neurali artificiali ma con molti “strati” (da cui il termine “deep”) di “neuroni”, le architetture di deep learning si sono dimostrate particolarmente efficaci nell’elaborazione sia di dati strutturati che non strutturati, come immagini, testo e audio, e sono oggi responsabili di molti dei risultati più spettacolari ottenuti negli ultimi anni nel campo dell’intelligenza artificiale.

Ma torniamo ai metodi per addestrare reti neurali su dati reali. L’idea di assegnare dei “pesi” ai collegamenti tra neuroni artificiali sorge dall’ispirazione di imitare il funzionamento del cervello biologico, dove la forza delle sinapsi influenza la trasmissione dell’informazione. Da qui, il passo successivo fu immaginare un meccanismo di apprendimento basato sulla modifica graduale di questi pesi, in risposta agli errori commessi durante il confronto tra le uscite prodotte dalla rete neurale e i risultati attesi. E questo divenne tecnicamente possibile con l’introduzione e la diffusione dell’algoritmo di “backpropagation”, che ha permesso l’addestramento di reti neurali anche complesse, a molti strati, aprendo la strada al deep learning. Al tempo stesso, un altro fattore decisivo nella rinascita dell’IA è stata la diffusione delle GP-GPU (“general-purpose graphics processing unit”): originariamente progettati per la grafica, questi dispositivi si sono rivelati ideali anche come acceleratori per svolgere in parallelo i numerosissimi calcoli necessari all’addestramento delle reti neurali, riducendo drasticamente i tempi necessari. Con la potenza di calcolo delle GP-GPU, la disponibilità di grandi volumi di dati digitali eterogenei (“big data”), i metodi di ottimizzazione e gli algoritmi di allenamento giunti a piena maturazione, tutti gli ingredienti erano finalmente sul tavolo: dopo oltre mezzo secolo, modelli teorici solidi hanno trovato terreno fertile per una loro applicazione efficace, e il deep learning è potuto diventare realtà, segnando l’inizio di una “primavera” dell’IA che, ad oggi, non sembra avere fine.

c.

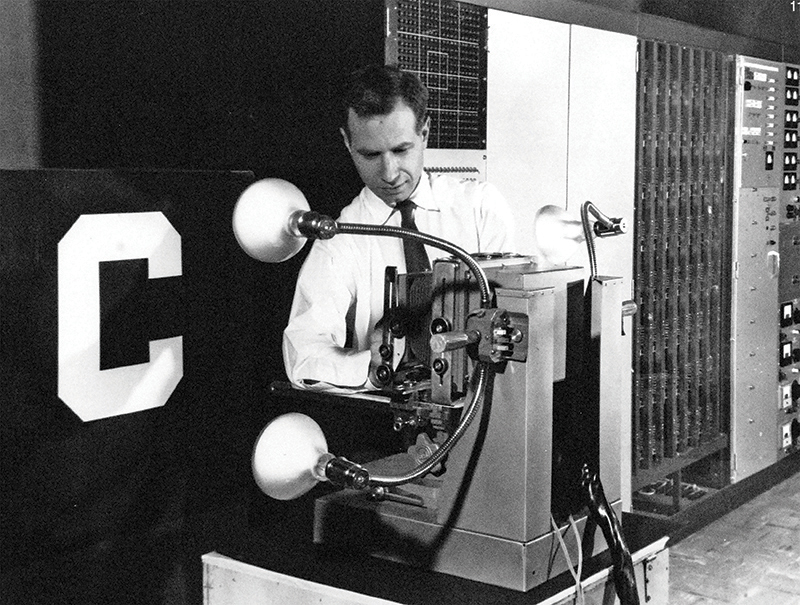

A sinistra John Hopfield e a destra Geoffrey Hinton, premi Nobel per la fisica del 2024 per le loro scoperte e invenzioni fondamentali che permettono l’apprendimento automatico con reti neurali artificiali.

Nel giro di pochi anni, concentrati nella seconda decade del XXI secolo, le reti neurali hanno vissuto un’esplosione di architetture innovative, ciascuna progettata per un diverso tipo di dato o di compito da svolgere (vd. anche Caduti nella rete (neurale), ndr). Le Convolutional Neural Network (CNN o ConvNet, reti neurali convoluzionali) hanno rivoluzionato la visione artificiale, diventando lo standard per il riconoscimento di immagini, volti e ogni tipo di schema o configurazione spaziale (in gergo “pattern”). Le Recurrent Neural Network (RNN, reti neurali ricorrenti) – insieme a varianti più stabili come le Long Short-Term Memory (LSTM) – hanno permesso alle reti neurali di gestire dati sequenziali e temporali, come ad esempio testi, suoni e in generale segnali di vario tipo. Gli Autoencoder (AE) hanno aperto la strada a tecniche di compressione, ricostruzione e riduzione dimensionale, fungendo anche da base per metodi di identificazione di anomalie (“anomaly detection”). L’introduzione delle Generative Adversarial Network (GAN, reti generative antagoniste) – in cui due reti in competizione tra loro riescono a creare immagini e contenuti sintetici di sorprendente realismo – hanno cambiato il modo di pensare la generazione di dati. Il passaggio dai modelli discriminativi di IA, progettati per distinguere e classificare dati esistenti, ai modelli generativi di IA, capaci di produrre autonomamente nuovi contenuti ad alto realismo, ha segnato un cambio di passo radicale: l’IA è passata dall’analizzare la realtà al saperne creare di nuove. In quest’ambito, più recentemente, i Diffusion Models (modelli di diffusione) hanno assunto un ruolo di primo piano nella generazione condizionata di dati guidata da istruzioni testuali (in gergo “prompt”), specialmente nel caso di immagini e audio. Infine, l’arrivo dei Transformer ha segnato una svolta epocale: progettati inizialmente per il “linguaggio naturale” (testo scritto o parlato), si sono rapidamente estesi a ogni tipo di dato – dal DNA alla musica – grazie al meccanismo di self-attention, diventando la spina dorsale dei Large Language Models (LLM), ovvero modelli linguistici di grande scala, e più in generale della nuova era dell’IA generativa.

Un riconoscimento importante per la storia dell’IA è arrivato nel 2024, con l’attribuzione di premi Nobel che toccano l’IA da molto vicino. Il Nobel per la chimica 2024 è stato assegnato a Demis Hassabis e John M. Jumper per lo sviluppo di un modello di IA capace di prevedere la struttura tridimensionale delle proteine: premiando la soluzione di un problema aperto da oltre 50 anni nella biologia strutturale, questo riconoscimento testimonia come lo sviluppo di tecniche basate su IA possa essere trasformativo nella progettazione di nuovi composti molecolari.

Il Nobel per la fisica del 2024 è stato conferito a John J. Hopfield e Geoffrey E. Hinton.

Hopfield nel 1982 ha introdotto il modello di rete neurale che tuttora porta il suo nome, capace di rappresentare configurazioni di attività neuronale che corrispondono a pattern appresi, seguendo principi ispirati alla fisica statistica. Hinton ha successivamente sviluppato la macchina di Boltzmann, una rete neurale stocastica che modella la distribuzione di probabilità dei dati attraverso una funzione di energia, e che ha avuto un ruolo fondamentale nella diffusione dell’algoritmo di backpropagation, già menzionato, come elemento chiave nell’evoluzione del deep learning. In questo caso, il riconoscimento dell’Accademia svedese è rivoluzionario non solo per i contenuti premiati, ma anche per la scelta di sancire in modo autorevole che siamo di fronte a un punto di svolta sul piano epistemologico, in cui viene sfumata una linea di confine che tradizionalmente esisteva tra due discipline – la “computer science” e la fisica – quando esse si muovono su temi di IA, terreno in cui si influenzano e arricchiscono reciprocamente, procedendo insieme in un dialogo profondo e comune attorno a un tema di ricerca di assoluta frontiera. Con un cuore che batte nella fisica, quindi, la ricerca sull’IA viene ormai sempre meno percepita come una disciplina informatica o ingegneristica in senso stretto o esclusivo, e si tende invece a evidenziarne e rafforzarne sempre più i ricchi e fertili aspetti multiculturali e multidisciplinari. Le basi teoriche dell’IA affondano le proprie radici in modo profondo nella fisica, in particolare nella fisica statistica e nella teoria dei sistemi complessi (vd. Cogito ergo \sum, ndr). Molti metodi che sono stati sviluppati per affrontare problemi in meccanica statistica, ad esempio, sono oggi strumenti chiave negli algoritmi di ottimizzazione e nell’addestramento delle architetture di reti neurali moderne. Le reti neurali stesse possono essere interpretate come sistemi complessi ad alta dimensionalità, in cui emergono proprietà collettive non previste dal comportamento dei singoli elementi, un ambito che la fisica conosce e studia da decenni.

Il legame tra fisica e intelligenza artificiale non è solo teorico: è diventato sempre più operativo e strategico. In campi come la fisica delle alte energie, l’astrofisica, la fisica dei materiali o la fisica medica, l’IA è ormai uno strumento indispensabile per analizzare ingenti volumi di dati, individuare pattern nascosti, identificare comportamenti anomali, simulare fenomeni complessi e – in ultima analisi – accelerare l’interpretazione sperimentale. Ma è sempre bene ricordare che la fisica non è soltanto un “cliente” dell’IA, ovvero uno dei domini applicativi di tecniche basate su reti neurali artificiali, ma è anche una delle sorgenti più profonde di ispirazione, innovazione e metodologia per la ricerca sull’IA.

Biografia Daniele Bonacorsi è professore di fisica sperimentale all’Università di Bologna. Lavora da tempo in esperimenti al CERN con acceleratori di particelle. Ha lavorato alla progettazione, sviluppo e messa in opera della Grid per gli esperimenti di LHC ed è stato coordinatore internazionale del calcolo scientifico dell’esperimento CMS a LHC, dove ha promosso l’adozione di tecniche di machine learning e deep learning. Tiene corsi di deep learning e quantum machine learning e coordina il dottorato in data science and computation all’Università di Bologna.