[IA]

anno 20 numero 39 / 10.25

Biografia

Stefano Forte è professore ordinario di fisica teorica all’università di Milano dal 2003, dopo aver occupato posizioni di ricerca a Saclay (Parigi), al CERN e nell’INFN a Torino e Roma. Fin dai primi anni 2000 ha usato tecniche di intelligenza artificiale per la comprensione della struttura del protone.

Come ti leggo dentro

Applicazioni in fisica teorica

di Stefano Forte

L’intelligenza artificiale (IA) pervade il mondo della ricerca e sta entrando prepotentemente in molti aspetti della vita quotidiana. Nell’ambito della fisica teorica, il ruolo dell’IA è particolarmente significativo nella fisica delle particelle elementari.

Compito della fisica teorica delle particelle è formulare le leggi che descrivono le forze fondamentali della natura, che vengono messe alla prova confrontandole con i dati sperimentali, quali quelli provenienti dal CERN di Ginevra. La teoria permette di calcolare che cosa succede quando due protoni si scontrano frontalmente nel grande acceleratore di particelle LHC del CERN. I protoni sono fatti di costituenti elementari: si tratta dei quark, e dei gluoni che li legano assieme. In particolare, la teoria permette di combinare l’informazione sulla struttura del protone in termini di questi costituenti, con il calcolo di ciò che accade quando due costituenti si scontrano, producendo nuove particelle elementari: per esempio altri quark. Questi quindi si ricombinano fra loro, formando altre particelle dette “adroni”, come ad esempio protoni o neutroni, che vengono visti mediante i rivelatori, giganteschi strumenti che ne intercettano il passaggio.

Diversi aspetti della procedura che porta dalla teoria fondamentale alla predizione di ciò che vede il rivelatore sono impossibili da affrontare con carta e penna. Innanzitutto, non si è attualmente in grado di calcolare come quark e gluoni sono legati dentro al protone: si tratta di un calcolo troppo difficile. L’interazione fra quark e gluoni invece si riesce a calcolare, ma al livello di precisione attuale è necessario manipolare espressioni algebriche fatte di migliaia o a volte anche milioni di termini. Infine, la ricombinazione dei quark in adroni che lasciano un segnale nel rivelatore è un processo troppo complicato per essere calcolabile.

Il modo tradizionale di affrontare questi problemi è sfruttando tecniche di simulazione numerica (vd. Particelle a colori, ndr) e di manipolazione algebrica svolte da un computer. Ma l’intelligenza artificiale sta cambiando tutto, specialmente grazie alle tecniche sviluppate negli ultimi dieci anni: deep learning e modelli generativi. Vediamo come.

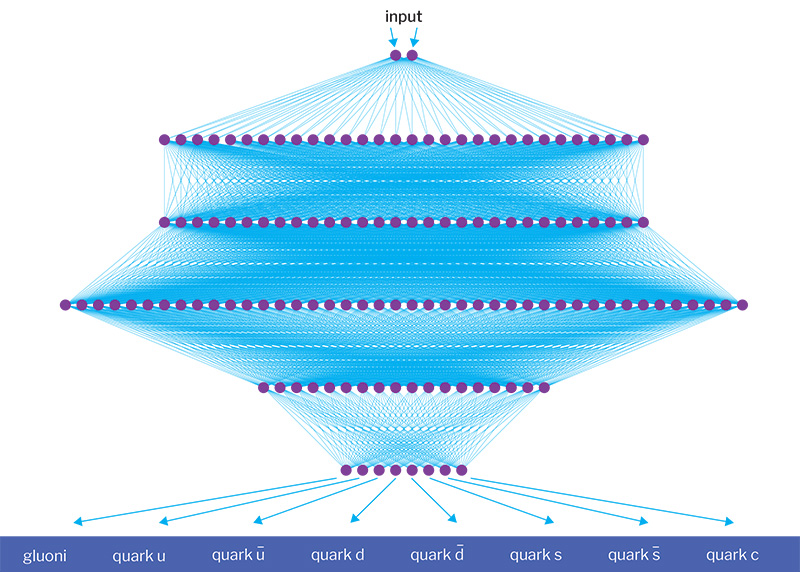

Partiamo dalla struttura del protone: ci serve conoscerla per predire quello che succede quando due protoni si scontrano. Ma non la sappiamo calcolare: e dunque? Il modo tradizionale di procedere è attraverso la modellizzazione: si ipotizza un modello matematico con molti parametri indeterminati. Lo si usa per calcolare che succede quando due protoni si scontrano. Si confrontano i risultati con ciò che si osserva, e si scelgono i valori dei parametri che danno il migliore accordo. L’IA suggerisce di procedere diversamente. Supponiamo di vedere un’immagine, e dover decidere se si tratta di un cane o un gatto. Potremmo cercare di trovare un modello: un’equazione che distingue il cane dal gatto, ad esempio descrivendo la forma del muso. Ma con l’IA possiamo insegnare a una rete neurale a distinguere il cane dal gatto partendo da un addestramento supervisionato, cioè mostrando molti esempi finché la rete neurale non ne estrae le caratteristiche distintive. Analogamente, possiamo mostrare molti dati di collisioni fra protoni a una rete neurale, finché questa ne estrae la struttura del protone in termini di quark e gluoni. Grazie al deep learning si può non solo imparare come è fatto un protone, ma anche qual è il miglior modo di ottenere questo risultato. In una prima fase (iper-ottimizzazione) si determinano le caratteristiche ottimali della rete neurale e del metodo da usare per addestrarla. In una seconda fase la rete ottimale “impara” la struttura del protone.

b.

Schema di una rete neurale utilizzata per descrivere la struttura interna del protone. L’input (in alto) rappresenta la frazione longitudinale della quantità di moto dei costituenti del protone (quark e gluoni). Gli output (in basso) sono le probabilità che ciascun costituente porti proprio quella percentuale di quantità di moto. La rete neurale è costituita da vari livelli, ognuno composto da un diverso numero di neuroni (i pallini viola), collegati tra di loro da link (linee continue)

Passiamo alla relazione fra il calcolo dei prodotti della collisione e le tracce nel rivelatore. Tradizionalmente lo si affronta con il metodo Monte Carlo: ogni passo del cammino che porta dai quark prodotti nella collisione, alla loro ricombinazione con altri quark per formare gli adroni, e infine all’interazione di questi ultimi con il rivelatore, viene simulato numericamente al computer (vd. anche Il casinò della fisica, ndr). Confrontando i risultati simulati con quelli reali è possibile ricostruire, a partire da ciò che si osserva, che cosa ha prodotto la collisione. L’IA generativa affronta il problema usando la stessa tecnica che permette di scrivere un pezzo di musica nello stile di Beethoven: ne è un esempio l’uso delle Reti Generative Avversarie (GAN). Una rete neurale, il generatore, viene addestrata a generare dei dati artificiali.

Nel nostro caso, a partire dalle tracce in un rivelatore lasciate da particelle prodotte in una collisione, il generatore produce un evento artificiale che si manifesta proprio con quelle tracce. Le tracce e l’evento generato vengono mostrate a un’altra rete neurale, il discriminatore, che deve capire se quello che sta vedendo è un vero evento, o un evento generato artificialmente. Il generatore e il discriminatore competono, e si migliorano a vicenda, finché il generatore non riesce più a distinguere gli eventi veri da quelli artificialmente prodotti dal generatore. A questo punto, il generatore produce risultati indistinguibili da quelli reali, e dunque fornisce lo strumento desiderato, che dalle tracce ricostruisce l’evento soggiacente.

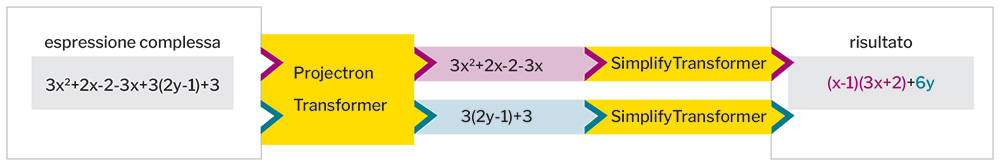

Infine, la semplificazione di espressioni algebriche. Tradizionalmente si usa la computer algebra: l’elaboratore applica ripetutamente regole di trasformazione, un po’ come i prodotti notevoli che si imparano alla scuola media. L’IA generativa affronta il problema con lo strumento usato dai Large Language Models (LLM) come ChatGPT: il Transformer. Questo prende in ingresso una sequenza e la completa: ad esempio le successive battute di un dialogo, in cui l’ultima è la domanda che facciamo a ChatGPT, e il completamento è la risposta di ChatGPT. Nel caso che ci interessa, un Transformer raggruppa i termini che possono essere semplificati, e un altro esegue la semplificazione. Come nei LLM, il Transformer procede in modo intuitivo: non applica delle regole prefissate, ma impara dall’esperienza sulla base di esempi. La forza del metodo è che se anche ogni tanto il Transformer sbaglia, non importa: si può sempre verificare se l’espressione inziale e quella semplificata danno lo stesso risultato; altrimenti, il risultato si scarta e si ricomincia.

c.

Una coppia di Transformer esegue la semplificazione di un’espressione algebrica: il primo raggruppa termini simili, il secondo li semplifica

Le tecniche che abbiamo visto sono di crescente complessità, e portano alla frontiera del progresso dell’IA in fisica teorica. Si tratta di un progresso bidirezionale. Da un lato, algoritmi sempre più avanzati forniscono strumenti di conoscenza sempre più potenti. Dall’altro, le esigenze della fisica teorica fanno da motore dello sviluppo di metodi sempre più sofisticati. L’intelligenza artificiale diventa così uno strumento per produrre conoscenza.

Biografia Stefano Forte è professore ordinario di fisica teorica all’università di Milano dal 2003, dopo aver occupato posizioni di ricerca a Saclay (Parigi), al CERN e nell’INFN a Torino e Roma. Fin dai primi anni 2000 ha usato tecniche di intelligenza artificiale per la comprensione della struttura del protone.